Die Manipulation der Öffentlichkeit durch Fehl- und Falschinformationen oder Verschwörungstheorien im digitalen Umfeld durch verschiedene Akteure bereitet vielen Experten und Politikern große Sorgen. Big Data Analytics, Künstliche Intelligenz, Automatisierung und andere Technologien werden zunehmend eingesetzt um öffentliche Institutionen, demokratische Grundsätze, Unternehmen, Wissenschaft, Medien oder Individuen zu untergraben. Doch man kann damit auch andere Cyberattacken im Rahmen von Social Engineering verbreiten (z.B: Erpressung, Diebstahl von Firmengeldern oder sensitiven Daten via „CxO / Chef Betrug“), Aktienkurse manipulieren, sie bei HR Streitigkeiten einsetzen oder Videos (z.B. von Überwachungskameras) für die Unterstellung von Straftaten verwenden. Umgekehrt können Individuen auch behaupten, echte (kompromitierende) Videos, seien falsch.

Dazu gehören Deepfakes. Mit der Technologie mit der Hollywoodstars und andere Personen in Forrest Gump, Star Wars oder Fast & Furious zum Leben erweckt werden, können Videos, Tonaufnahmen und Bilder manipuliert werden. Damit können nicht existente Personen erstellt werden (der Fall Oliver Taylor zur Diskreditierung von Mazen Masri welcher an einem Gerichtsverfahren gegen die israelische NSO Group beteiligt war) sondern auch existierenden Personen wie Bundeskanzlerin Dr. Angela Merkel, Joe Biden, Mark Zuckerberg oder Frank Appel Aussagen „in den Mund gelegt“ werden, die in kurzer Zeit aufgrund der schnellen Verbreitungswege über das Internet für Verunsicherung oder Aufruhr sorgen können. Für die Umsetzung wird lediglich ein Computer, Internetverbindung und weniger als 500 Euro benötigt. Komplexere Vorhaben bauen auf andere Technologien oder Schauspieler.

Was sind Deepfakes?

Das Wort Deepfake ist ein Zusammenschluss aus den Wörtern „Deep Learning“ und „Fake“ – ein gefälschtes Medium, welches mit Hilfe von Deep Learning Algorithmen, also Künstlicher Intelligenz erstellt wurde.

Die Grundlage für die Technik wurde 2014 von dem Doktorand Ian Goodfellow gelegt. Er erfand die Generative Adversarial Networks oder GAN. Dieses Verfahren besteht aus zwei neuronalen Netzen, dem Generator und dem Diskriminator. Das Ziel des Generators ist es dabei zu lernen, neue Medien zu erstellen. Der Diskriminator wird hingegen darauf trainiert, die Ergebnisse des Generators von den echten Daten zu unterscheiden. Ziel ist es dadurch falsche Medien zu erzeugen. Solche Medien wirken täuschend echt, sind es aber nicht. Allerdings können nicht nur Videos gefälscht werden, sondern auch Fotos oder Audiodateien.

Thorsten Skywalker (2020)

Wie bereits erwähnt wird diese Technologie in Hollywoodproduktionen genutzt um klassische CGI zu ersetzten. So konnte in „Gemini Man“ eine 23 jährige Version von Will Smith als Clon eingefügt werden. Und wir konnten im Rahmen dieses Beitrags unseren Managing Director Thorsten Ecke auf einfache Weise Teil der Star Wars Filme „The Last Jedi“ und „The Rise of Skywalker“ werden lassen und Marc Hamill ersetzen.

Ein CEO eines englischen Energieversorgers wird von dem CEO der deutschen Mutterfirma angerufen. Dieser gibt die Bezahlung eines Zulieferers in Auftrag. Der Mitarbeiter befolgt die Anweisung und überweist 243.000$ an ein ungarisches Bankkonto. Am nächsten Tag stellt sich heraus, dass dieser gar nicht angerufen hat. Ein Betrüger hat mit Hilfe von Deepfake Audio die Stimme des CEOs gefälscht. Dieser Fall ist der erste weltweit, bei dem durch diese Technologie ein wirtschaftlicher Schaden angerichtet wurde.

Deepfakes können aber auch zur Beeinflussung der Politik anderer Länder genutzt werden. So sind die USA laut einem Bericht von Brookings Institute schlecht auf eine Desinformationskampagne vorbereitet – gerade wenn man an den Wahlkampf für den nächsten Präsidenten der USA in 2020 denkt. So hat bereits eine russische Kampagne versucht die Wahl Macrons im Jahr 2017 zu verhindern. Bei einem schlechter vorbereiteten Kandidaten oder mit den Deepfakes der jetzigen Generation hätte das vielleicht funktioniert.

Aber nicht nur Gesichter und Menschen können verändert werden. Forscher der Carnegie Mellon Universität haben bereits 2018 mit ihrem Recycle-GAN Ansatz andere Elemente wie Blumen, Landschaften oder das Wetter in Videos manipuliert.

Die Hauptnutzung liegt jedoch weiterhin bei der Erstellung von pornografischen Inhalten. So sind lauter einer Studie von Deeptrace, einer Cybersecurity Firma, 96% aller Fake Videos online pornographischer Natur, bei denen Gesichter von Models, Film- und Musikstars auf die Gesichert von den Pornodarstellern gesetzt werden.

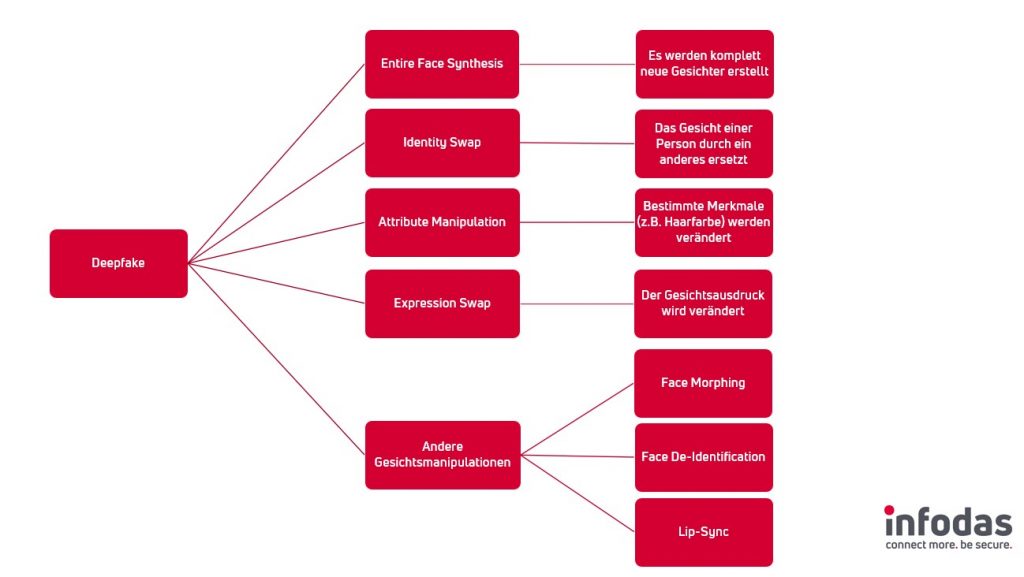

Kategorien von Deepfakes

Die am häufigsten vorkommenden Deepfakes werden nachfolgend noch genauer erläutert:

Identity Swap:

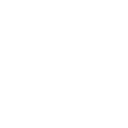

Amy Adams / Nicholas Cage face swap

Dabei wird ein Gesicht in einem Video oder Foto automatisch mit einem anderen Gesicht getauscht. Beispiele dafür sind Filme, bei welchen der Hauptcharakter durch andere ersetzt wird oder die als Spaß genutzte Funktion in der Socialmedia App Snapchat. Ein Internetphänomen ist der Austausch von Haupcharakteren in Filmen durch Nicholas Cage.

Lip-Sync:

Hier wird nur der Mundbereich des Gesichts verändert und Menschen auf Videos werden dazu gebracht, etwas zu sagen, was sie nie gesagt haben. Das prominenteste Beispiel ist dabei das Video, auf welchem Ex-Präsident Barack Obama dazu gebracht wurde, Präsident Trump als „total and complete dipshit“ zu beleidigen.

Expression Swap

Diese wird teilweise als gefährlichste Kategorie angesehen. Dabei wird das Gesicht der Zielperson von einer anderen Person komplett animiert, die vor der Kamera sitzt. Ähnlich wie das von Apple vorgestellte Feature „Animoji“, nur mit einer echten Person. Als Beispiel hier ein Video, bei dem eine Person, bei einen Nachrichtenbeitrag des Senders CNN, Ex-Präsident George Bush komplett animiert.

Neueste Trends

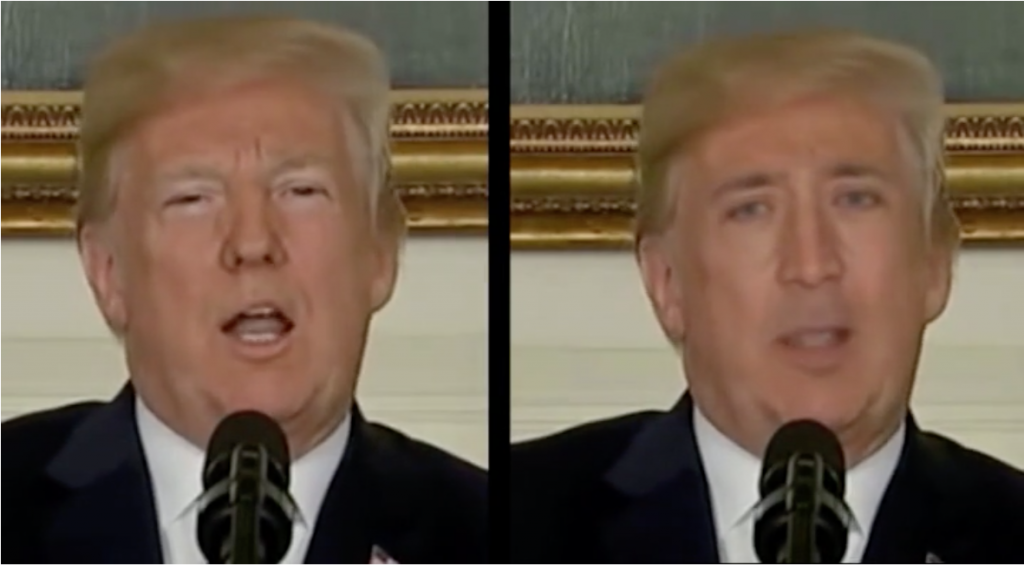

Deepfakes werden immer besser und häufiger. Allein in einem Zeitraum von neun Monaten ab Anfang 2019 stieg laut dem Startup Deeptrace die Zahl von Deepfake Videos von 7.964 auf 14.678. Diese immer anspruchsvolleren Deepfakes sind aber auch immer schwerer von den derzeitigen Algorithmen zu erkennen. So sind viele Probleme welche von der ersten Generation an Deepfakes, wie die sichtbaren Grenzen zwischen Maske und dem originalen Gesicht oder geringe Posen Variation, bereits in der zweiten Generation gelöst. Siehe dazu die beiden nachfolgenden Beispiele:

Nicholas Cage ersetzt Donald J. Trump (2018)

Steve Buscemi ersetzt Jennifer Lawrence (2019)

Das Thema Deepfakes beschäftigt viele Bereiche der Forschung – es werden vor allem Technologien aber auch Auswirkungen auf Gesellschaft, Politik und Wirtschaft untersucht. DARPA, die Forschungseinrichtung des US Militär, hat in den letzten zwei Jahren 68 Millionen Dollar für Technologien zur Deepfakeerkennung ausgegeben und hierfür auch erste Softwaretools entwickelt.

Prof. Luisa Verdoliva von der Universität Frederico II aus Neapel forscht zum Thema „Preserving Media trustworthiness in the artificial Intelligence era“. Davor wurde sie bereits für ihr Paper „Extracting camera-based fingerprints for video forensics“ ausgezeichnet. Durch die Identifikation der Kamera, mit welchen Fotos aufgenommen werden, können so Unterschiede zwischen Fake und Original erkannt werden. Auch die Technische Universität München ist bei Deepfakes federführend. So hat Matthias Nießer, Professor für Visual Computing, zusammen mit der Universität Erlangen-Nürnberg und der eben erwähnten Universität Frederico II aus Neapel eine Arbeit mit dem Thema „FaceForensics++: Learning to Detect Manipulated Facial Images“ veröffentlicht. Daneben ist auch das Projekt „DIGGER“ des Fraunhofer IDMT mit dem Kampf gegen Deepfakes beschäftigt. Weitere nennenswerte Universitäten sind IDIAP aus Martigny in der Schweiz, die University at Albany (SUNY), UC Berkley und University of Maryland. An der Helmut-Schmidt-Universität/Universität der Bundeswehr beschäftigen sich die Lehrstühle „Digitale Demokratie“ und „Hybride Bedrohung“ mit der Thematik.

Sowohl für die Herstellung wie auch für die Erkennung von Deepfakes sind eine Vielzahl an Daten nötig, um die Algorithmen zu trainieren. Organisationen mit dem größten Datenmaterial haben hier den größten Vorteil. Im Endeffekt spielen Technologieunternehmen, wie Facebook, Google und Twitter eine entscheidende Rolle. Facebook ist bereits im September 2019 eine Partnerschaft mit Microsoft und Amazon Webservices und einer Reihe Universitäten eingegangen, um mit der Deepfake Detection Challenge ein Projekt zur Programmierung eines besseren Deepfake Detektors zu fördern. An dem Projekt nahmen 2114 Teams aus aller ab September 2019 mit 35,000 verschiedenen KI-Modellen teil. Das beste Modell konnte 65.18% der manipulierten Videos aus einem unbekannten „Black Box“ Datensatz von 10,000 Videos erkennen. Bei einem bekannten Datensatz mit 100,000 Videos, erkannte das beste Modell 82.56%.

Abgesehen von der Erkennung werden gerade Programme entwickelt, welche automatisch Wasserzeichen zu Medien hinzufügen, welche nicht verändert werden können, um sie dann später verifizieren zu können. Ein anderer Ansatz ist die Entwicklung von Verifikationsmerkmalen durch Blockchain Technologie. Allerdings sind alle diese Technologien keine Lösung des Problems. Wie bereits mit Fakenews gezeigt wurde, heißt ein Beweis, dass ein Beitrag falsch ist nicht, dass es nicht angeschaut und geteilt wird. So kann auch ein schlechtes Fake, bereits als viraler Trend um die Welt gehen und geglaubt werden.

In den meisten Ländern – so auch in Deutschland – bestehen zudem Handlungsbedarfe in juristischer Hinsicht um den verschiedenen Aspekten von Deepfakes zu begegnen (z.B. Strafrecht, Markenrecht, Datenschutz). Mehrere US Bundesstaaten wie Virginia, Texas oder Kalifornien haben bereits Anpassungen ihrer Rechtsnormen veranlasst. Das Thema Deepfake war auch Teil des National Defense Authorization Act welcher am 20.12.2019 in Kraft trat. Auch im US Congress gibt es unterschiedliche Gesetzesvorhaben um Deepfakes zu regulieren.

Das Problem von Shallowfakes

Simple Manipulationen von Videos werden als Shallowfakes bezeichnet. Sie bedürfen keiner KI sondern grundlegende Kenntnisse von Video- und Audiobearbeitungssoftware. Videos müssen nicht einmal verändert werden. Sie werden einfach in einem neuen Kontext verwendet und setzen auf die Unachtsamkeit der Konsumenten, emotionale Trigger und die virale Verbreitung über die sozialen Medien. Durch Veränderungen wie Schnitt oder Geschwindigkeit sind ebenfalls Effekte erzielbar so wie wir sie auch von Überschriften in den Medien kennen, die Sachverhalte oder Aussagen von Personen aus ihrem Kontext darstellen.

Zum Beispiel wurde ein Video einer Person, die bei lebendigem Leib verbrennt, in verschiedenen afrikanischen Staaten über Social Media oder Messenger verbreitet um Gewalt anzustiften oder nach der Wahl Ende 2010 in der Elfenbeinküste das Narrative der Vorbereitung eines Genozid durch Anhänger des Präsidentschaftskandidaten Alassane Quattara zu stärken. Gleiches gilt für Videos von einem brennenden Gebäude aus Indien, welches verwendet wurde um Xenophobie in Südafrika zu schüren.

Auch ein selektives Zusammenfügen oder Reduzieren unveränderter Clips einer Rede kann ein völlig anderer Eindruck entstehen. Sagte ein Politiker etwa im Wahlkampf: „Mein Gegner behauptet, ich hasse mein Land, aber das ist völlig falsch“ kann der Gegner daraus auch nur „Ich hasse mein Land“ veröffentlichen. Gezielt zu bestimmten Zeitpunkten eingesetzt, wie an einem Wahltag, sodass keine Zeit zur Reaktion des „Opfers“ bleibt, und kombiniert mit den Microtargeting Möglichkeiten von Internetplattformen und -suchmaschinen, kann es wahlverändernde Auswirkungen haben. Auch die Veränderung des Abspielgeschwindigkeit (hier Nancy Pelosi, Sprecherin des Repräsentantenhauses der USA) kann unsere Wahrnehmung beeinflussen wie man an diesen Aufnahmen sieht.

In diesem Zusammenhang wird ein weitaus größeres Problem der Proliferation von manipulierten Inhalten sichtbar: Die unaufhaltsame Aushöhlung der Fundamente unserer eigenen Wahrnehmung und der Logik den Dingen vertrauen zu können die wir sehen, hören oder kennen. Wenn alles ein „Fake“ sein kann, weil wir ständig damit in Kontakt kommen, was und wem sollen wir dann noch trauen. Experten nennen das „Realitätsapathie“.

Ein bekanntes Beispiel für Realitätsapathie aufgrund von „Fakenews“ und „Deepfakes“ kommt im Jahr 2018/19 aus Gabun. Es gab dort Gerüchte, dass Präsident Ali Bongo nicht mehr gesund genug für sein Amt sei. Eine Neujahrsansprache vom 31.12.2018 wirkte wie ein Deepfake, war es jedoch im Nachhinein nicht. Bongos politische Gegner erklärten, das Filmmaterial sei eine Fälschung und der Präsident sei arbeitsunfähig oder tot. Die politische Lage destabilisierte sich und das Militär nutzte die Situation am 7.1.2019 für einen Putsch der innerhalb eines Tages beendet wurde.

Wie erkennt man Deepfakes?

Die erste Generation an Fakes konnte mit bloßem Auge erkannt werden. Die Kanten waren unscharf und die Videos sehr zittrig. Doch schon mit der zweiten Generation wurden sie innerhalb von ein paar Monaten kaum noch unterscheidbar vom Original.

In der klassischen Medienforensik kommen Methoden wie „Fingerabdrücke“ von Kameras (Hardware, Software) wie Interpolation, Kompression, optische Linsen oder Farbfilter zum Einsatz. Ebenfalls hinterlassen Editiersoftware wie Adobe Photoshop, Gimp oder Final Cut ihre Spuren in digitalen Medien (z.B. Kompressionsmethoden, Frameraten, etc.). Die Wirksamkeit hängt jedoch von den jeweiligen Trainingsszenarien für Algorithmen (Datensätzen) ab um auch neue Methoden erkennen zu können. Das wird zusätzlich erschwert, wenn Inhalte über Internetplattformen geteilt werden, die Inhalte automatisch modifizieren (z.B. Größe, Kompression)

Es gibt verschiedene Merkmale, auf welche heute Erkennungsalgorithmen trainiert werden können. Zum Beispiel „soft biometrics“, also Merkmale in der Mimik und Gestik, welche zu klein sind, um von den Deepfake Erstellungsalgorithmen erkannt zu werden. Ein Algorithmus kann gezielt darauf programmiert werden, diese soften Merkmale zu erkennen, wie etwa die Art wie eine Person die Lippen spitzt, bevor sie eine Frage beantwortet. Mit einer Genauigkeit von 92% können so Deepfakes erkannt werden.

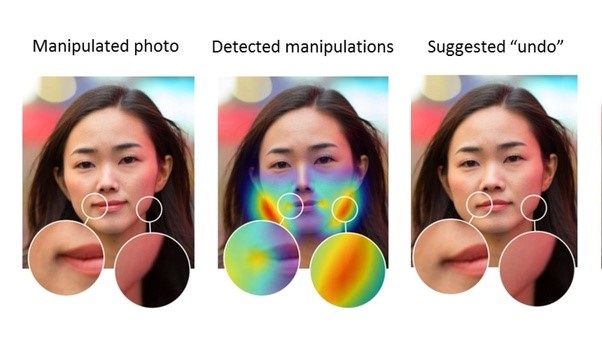

Es gibt ebenfalls die Möglichkeit Algorithmen auf sogenannte Artefakte zu trainieren, also Unstimmigkeiten, zwischen dem originalen Video und den Bereichen, welche verändert wurden. So werden Deepfakes normalerweise nur in bestimmten Auflösungen gemacht. Dies erfordert aber das der Bereich, welcher verändert wurde, beispielsweise das Gesicht, durch Verzerren angepasst werden muss. Dadurch entstehen Artefakte und diese können durch Algorithmen erkannt werden, wie im unteren Bild zu erkennen ist.

Sobald neue Forschungsergebnisse veröffentlicht werden, vergeht jedoch kaum Zeit, bis die Merkmale in Deepfake Algorithmen integriert werden. Bereits im Juni 2018 stellten Forscher ein Erkennungsmechanismus durch unnatürliche Blinzelmuster vor. Kurz nach Vorstellung der Technologie wurde das Blinzeln in die Syntheseverfahren aufgenommen. Die Erkennungsverfahren waren damit unbrauchbar. Man kann daher auch von einem Wettrüsten zwischen den Deepfake Herstellern und Forensikern sprechen.

Wie schützt man sich vor Deepfakes?

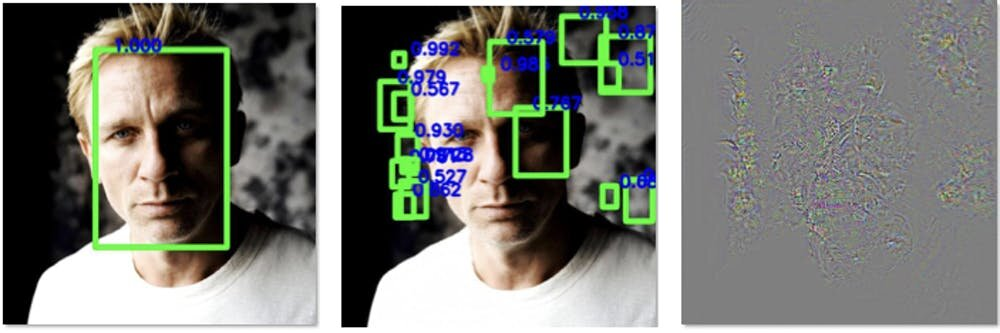

Es gibt Möglichkeiten die Veränderungen von Videos, Audioaufnahmen oder Bildern zu verhindern. So gibt es bereits Wege, Fotos und Videos mit bestimmten „Geräuschen“ zu versehen, welche für das menschliche Auge unsichtbar sind, aber Gesichtserkennungsalgorithmen täuschen. Pixelmuster, welche zur Gesichtslokalisierung verwendet werden, werden verdeckt. In anderen Bereichen, in welchen kein Gesicht vorhanden ist, können dann diese Pixelmusterhinzugefügt werden. So wird das Medium dann für die Manipulation unbrauchbar. Die Chancen für ein erfolgreichen Fake fallen.

In dem folgenden Bild sieht man links, das Bild ohne Bearbeitung. Der Algorithmus erkennt das Gesicht (grüner Rahmen) ohne Probleme. In der Mitte sieht man, dass der Algorithmus nach der Bearbeitung, viele Gesichter erkennt, aber nicht das eigentliche. Rechts ist dann die Änderungen, welche gemacht wurden, 30-fach verstärkt.

Wie auch bei vielen Angriffsvektoren in der Cybersicherheit, kann der Mensch durch eine veränderte Aufmerksamkeit und Verhaltensanpassung nach „Awareness Trainings“ die negativen Auswirkungen von Deepfakes verhindern oder eingrenzen–ganz ohne den Einsatz von Technologie. In kritischen Bereichen (Stichwort CxO/Chef Betrug) können bestimmte Sicherheitsprotokolle Deepfakeangriffe blockieren und es müssen analog zu Pandemie und Business Continuity Plänen auch Maßnahmen zum Umgang (z.B. Kommunikation bei Falschinformation) mit Deepfakes geben.

Wer kommerzialisiert die Deepfake Technologie?

In den letzten 2-3 Jahren sind zahlreiche Startups im Umfeld von Deepfake Technologien entstanden. Die Firma Topaz Labs etwa, welche eigentlich Software für die Bildbearbeitung vertreibt, nutzt Machine Learning in ihrem Produkt Gigapixel AI. Die Software erlaubt es Bilder mit geringer Auflösung sechshundertfach mit nie dagewesener Qualität zu vergrößern.

Auch das Start-up Modulate nutzt die Deepfake Technologie, um jede Stimme in die eines anderen zu verwandeln. Das Ziel ist es die Technologie an Social Media und Gaming Firmen zu lizensieren, um Nutzern ein Audio Avatar bereitzustellen. Große Techkonzerne wie Microsoft, Google, Amazon oder Adobe (Voco) arbeiten alle an Technologien zu Spracherkennung oder der Generierung syntethischer Klone. Ist eine Stimme erstmal erfasst, kann man einen Text schreiben und die KI erstellt das Audio. Auch Baidu aus China bietet mit Deepvoice eine Technologie an um auf Basis von nur wenigen Sekunden Datenmaterial eine echte Stimme zu klonen (Beispiele).

Die Firma Rosebud.AI erlaubt es, Avatare für computergenerierte Models für Kampagnen zu erstellen.

Apps wie Zao aus China oder Doublicat aus den USA bieten ebenfalls für jeden Smartphonebesitzer einfach zu verwendende Deepfaketechnologie an.

Ein weiteres Beispiel ist das Unternehmen MEO, welche aus einem zwei dimensionalen Gesicht einen drei dimensionalen Avatar erstellen kann. Die Technologie beachtet dabei auch Mikro-Ausdrücke, anders als die von Apple entwickelten Animoji. Doch auch für die Filmproduktion sind Firmen aktiv, welche die Deepfaketechnologie nutzen. So wie die neuseeländischen Weta Workshop, die für Gemini Man verantwortlich waren.

Die Technologie wird sich rasant weiterentwicklen und auf unterschiedlichste Weise eingesetzt werden. Bislang gibt es noch keinen etablierten Untergrundmarkt für Technologien für Deepfakes weil Nachfrage und Umsatzpotentiale fehlen. Dies kann sich jedoch jederzeit ändern. Der beste Schutz gegen Deepfakes bleibt eine gesunde Skepsis und Prüfung digitaler Inhalte bevor es zu Handlungen oder Meinungsbildungen kommt.

Quellen

Bendel, P. D. (kein Datum). Von Gabler Wirtschaftslexikon

Bradshaw, T. (10. Oktober 2019). Deepfakes: Hollywood’s quest to create the perfect digital human.

Bradshaw, S.; Howard, P. (2018) Challenging Truth and Trust: A Global Inventory of Organized Social Media Manipulation

Buzz Blog Box. (kein Datum). How Deepfake Technology Impact the People in Our Society?

Christian Vaccari, A. C. (19. Februar 2020). Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News.

Ciric, N. (25. September 2019). How to Protect Your Business From Deepfakes

Council on Foreign Relations (14. November 2018). Deep Fakes and the Next Generation of Influence Operations

Danzig, L. (2019). Is there any AI that can detect deepfake videos?

Deeptrace. (2018). The State of Deepfakes : Reality under Atteck.

Deutsche Bundesregierung. (02. Dezember 2019). Beschäftigung der Bundesregierung mit Deepfakes. Von Antwort der Bundesregierung auf eine Anfrage

Galston, W. A. (8. Januar 2020). Is seeing still believing? The deepfake challene to truth in politics. Von Brookings

Hao, K. (10. Oktober 2019). The biggest threat of deepfakes isn’t the deepfakes themselves

Johnson, B. (25. Mai 2019). Deepfakes are solvable—but don’t forget that “shallowfakes” are already pervasive

Kaspersky. (2020). kaspersky.com

Leetaru, K. (26. August 2019). The Real Danger Today Is Shallow Fakes And Selective Editing Not Deep Fakes

Lyu, S. (26. Juni 2019). Detecting ‚deepfakes‘ by looking closely reveals a way to protect against them

Marcel, P. K. (Dezember 2018). DeepFakes: a New Threat to Face Recognition? Assessment and Detection.

Pain, J. (04. Juli 2011). Beware of internet misinformation: hoax footage of atrocities in Ivory Coast.

Price, M. (14. Oktober 2019). Deepfakes and their potential impact on society

PricewaterhouseCooper Australia. (27. März 2019). From pornography to presidents: Why business needs to pay attention to deepfakes

Robitzski, D. (19. November 2018). DARPA Spent $68 Million on Technology to Spot Deepfakes

Ruben T., et. al. (16. April 2020). Deepfakes Evolution Analysis of Facial Regions ans Fake Detection Perfection

Ruben T., et. al. (18. June 2020) DeepFakes and Beyond: A Survey ofFace Manipulation and Fake Detection

Schwartz, O. (12. Nov. 2018). You thought fake news was bad? Deep fakes are where truth goes to die

TACKHYUN JUNG, S. K. (15. May 2020). DeepVision: Deepfakes Detection UsingHuman Eye Blinking Pattern

Thanh Thi Nguyen, C. M. (25. September 2019). Deep Learning for Deepfakes Creation and Detection

Thomas, B. (Dezember 2019). How to Protect your Organization from the Emerging Deepfake Threat

Toews, R. (25. Mai 2020). Deepfakes Are Going To Wreak Havoc On Society. We Are Not Prepared

Verdoliva, L. (2019). Extracting camera-based fingerprints for video forensics. Von CVPR Workshop: Extracting camera-based fingerprints for video forensics abgerufen

Vincent, J. (28. Juni 2019). Deepfake detection algorithms will never be enough

Volkert, R. (2020). Deep FakesUnderstanding the illicit economy for synthetic media

Wang, C. (1. November 2019). Deepfakes, Revenge Porn, And The Impact On Women

Wilson, M. (23. April 2019). Startups are racing to commercialize DeepFakes’s powerful, internet-breaking AI

YISROEL MIRSKY, W. L. (12. Mai 2020). The Creation and Detection of Deepfakes: A Survey. Georgia Institute of Technology and Ben-Gurion University